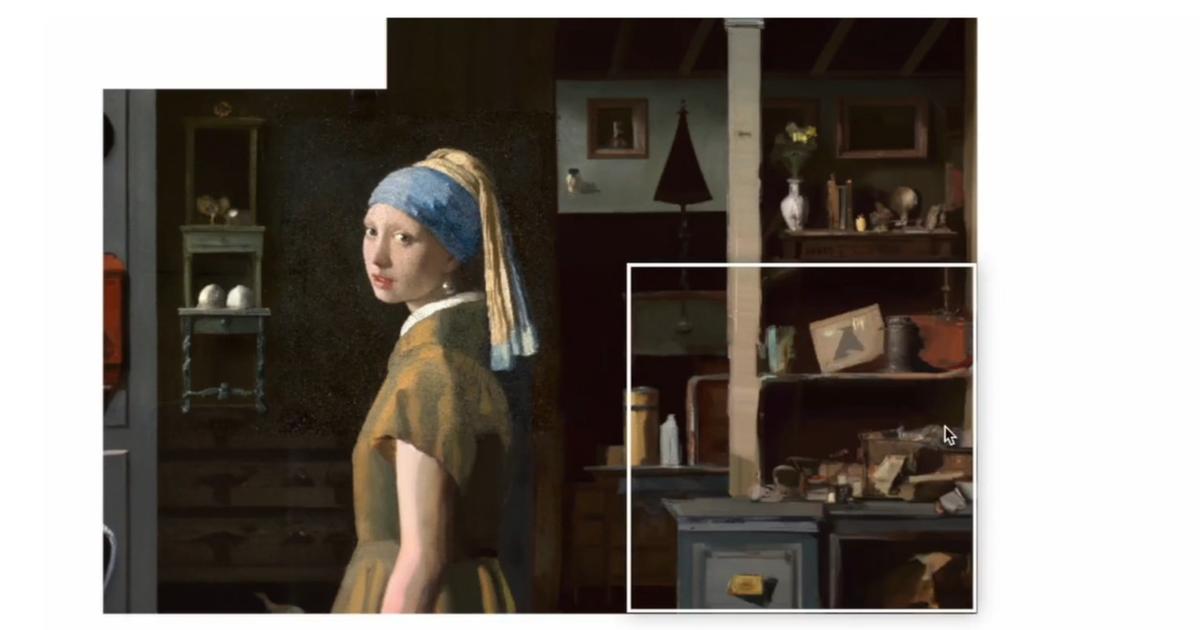

Glaze, opracowane przez Uniwersytet w Chicago, dodaje do swoich prac tagi, które mylą sztuczną inteligencję, gdy ponownie wykorzystuje prace artystów.

W obliczu powszechnego wykorzystywania danych przez niektórych twórców sztucznej inteligencji artyści, z pomocą badaczy uniwersyteckich, celowo zamykają swoje dzieła w pułapkę, aby uczynić je bezużytecznymi. Paloma McLean to amerykańska malarka. Wiele kreatywnych programów AI pozwala już na tworzenie obrazów inspirowanych stylem danej osoby, mimo że artysta nigdy nie wyraził na to zgody i nie będzie z tego czerpał korzyści finansowych. „Martwiło mnie to», wyjaśnia projektant mieszkający w Houston (Teksas). „Nie jestem znanym artystą, ale nie czułem się komfortowo z pomysłem wykorzystania mojej pracy do przywództwa» Model sztucznej inteligencji. Aby temu zaradzić, prowadzi swój biznes poprzez Glaze, program, który dodaje do jej ilustracji niewidoczne dla ludzkiego oka piksele, aby zakłócić pracę sztucznej inteligencji.

Po tej obróbce powstałe obrazy ulegają rozmyciu, a twarze rozmyciu, bez porównania z oryginałami. „Staramy się zapewnić narzędzia technologiczne chroniące twórców przed niewłaściwym wykorzystaniem generatywnych modeli sztucznej inteligencji„, wyjaśnia Ben Zhao, badacz z Uniwersytetu w Chicago, który stworzył swój zespół Glazura.

Przeczytaj takżeNowa piosenka Beatlesów zostanie opublikowana dzięki sztucznej inteligencji 2 listopada

„niebezpieczny problem”

Ten profesor informatyki został powiadomiony w listopadzie 2022 r. i opracował oprogramowanie w zaledwie cztery miesiące, wykorzystując wcześniejsze prace mające na celu wyłączenie rozpoznawania twarzy. „Pracowaliśmy na pełnych obrotach, bo wiedzieliśmy, że problem jest poważnyMówi Ben Zhao. Wiele osób cierpiało.»

Giganci generatywnej sztucznej inteligencji zawarli umowy mające na celu zabezpieczenie praw do korzystania z niektórych treści, ale zdecydowana większość danych, obrazów, tekstów i dźwięków wykorzystanych do opracowania modeli została stworzona bez wyraźnej zgody. Według badacza, którego jednostka przygotowuje się do uruchomienia nowego programu o nazwie Nightshade, od chwili premiery Glaze pobrano ponad 1,6 miliona razy.

Koncentruje się na prostych zapytaniach językowych (podpowiedziach) wysyłanych przez użytkownika generatywnego modelu AI w celu uzyskania nowego obrazu. Ma to na celu wykolejenie algorytmu, który następnie wyświetli na przykład zdjęcie kota, gdy zostanie poproszony o psa.

Inna inicjatywa, startup Spawning, opracowała Kudurru, oprogramowanie wykrywające próby mobów na platformach fotograficznych. Artysta ma wówczas możliwość zablokowania dostępu do swojej pracy lub przesłania innego obrazu niż żądany.”Co jest równoznaczne z zatruciem» Model AI jest w fazie rozwoju i wpływa na jego niezawodność – opisuje Jordan Mayer, współzałożyciel Spawning. Z siecią Kudurru zintegrowano już ponad tysiąc stron internetowych.

Powstała także wylęgarnia.Czy zostałem przeszkolony? (haveibeentrained.com), witryna śledząca, czy obrazy zostały wprowadzone do modelu sztucznej inteligencji, i dająca właścicielowi możliwość ochrony przed nieuprawnionym użyciem w przyszłości. Oprócz obrazu badacze z Washington University w St. Louis (Missouri) zainteresowali się dźwiękiem i opracowali moduł AntiFake.

” Celem jest, aby ludzie mogli chronić swoje treści, niezależnie od tego, czy są indywidualnymi artystami, czy firmami posiadającymi znaczną ilość własności intelektualnej „,

Bin Zhao, badacz z Uniwersytetu w Chicago

Oprogramowanie to wzbogaca plik audio o dodatkowe dźwięki, które są niedostrzegalne dla ludzkiego ucha, uniemożliwiając niezawodne naśladowanie ludzkiego głosu, wyjaśnia Chi Yuanyu, doktorant odpowiedzialny za projekt. Program ma na celu w szczególności zapobieganie „Głębokie podróbki», wysoce realistyczne fotomontaże lub filmy, w których wykorzystuje się wygląd jakiejś osoby, często sławnej osoby, aby skłonić tę osobę do zrobienia lub powiedzenia czegoś.

Według Ziyuan Yu z zespołem kierowanym przez profesor Ning Zhang niedawno skontaktowali się producenci popularnego podcastu, którzy chcieli chronić go przed defraudacją. Choć obecnie jest on używany wyłącznie w przypadku języka mówionego, AntiFake może chronić także głosy piosenkarzy – uważa badacz, którego oprogramowanie jest dostępne bezpłatnie.

Do jednostki Bena Zhao zwrócił się „Wiele firm chce używać Nightshade do ochrony swoich obrazów i własności intelektualnej» – twierdzi naukowiec z Chicago. Nie jest nawet przeciwko dużym firmom korzystającym z jego oprogramowania.

„Celem jest, aby ludzie mogli chronić swoje treści, niezależnie od tego, czy są indywidualnymi artystami, czy firmami posiadającymi znaczną ilość własności intelektualnej„W przypadku składania jaj chodzi nie tylko o utrudnianie, ale także po drugie” – mówi Ben Zhao.Umożliwienie ludziom organizowania się w celu sprzedaży swoich danych za opłatą» – precyzuje Jordan Mayer, który zapowiada uruchomienie platformy na początek 2024 roku.najlepsze rozwiązanieWedług niego,Będzie to świat, w którym wszystkie dane wykorzystywane w AI będą podlegały zatwierdzeniu i zapłacie. Mamy nadzieję popchnąć programistów w tym kierunku.»

„Dumny fanatyk sieci. Subtelnie czarujący twitter geek. Czytelnik. Internetowy pionier. Miłośnik muzyki.”

More Stories

Edgerunners, serial animowany Netflix inspirowany światem Cyberpunka 2077

Manuela, nominowana do The Voice, wyeliminowana przez Jennifer, rozlicza się z piosenkarką

Jennifer Lawrence w Nowym Jorku założyła sukienkę z odkrytymi plecami i rozcięciem